Conversazioni tra LLM potrebbero automatizzare la creazione di exploit, mostra uno studio

19 luglio 2025

rubrica

di Ingrid Fadelli, Phys.org

redattore collaboratore

a cura di

Gaby Clark, recensito da Andrew Zinin

editore scientifico

editore responsabile

Questo articolo è stato revisionato secondo il processo editoriale e le linee guida di Science X. Gli editori hanno evidenziato i seguenti attributi garantendo la credibilità dei contenuti:

verificato

fonte affidabile

corretto

Con l'avanzare sempre maggiore dei computer e dei software, gli hacker devono adattarsi rapidamente alle ultime novità e ideare nuove strategie per pianificare ed eseguire cyberattacchi. Una strategia comune per infiltrare maliziosamente i sistemi informatici è conosciuta come exploit software.

Come suggerisce il nome, questa strategia prevede lo sfruttamento di bug, vulnerabilità o difetti nel software per eseguire azioni non autorizzate. Queste azioni includono l'accesso ai conti personali dell'utente o al computer, l'esecuzione remota di malware o comandi specifici, il furto o la modifica dei dati dell'utente o il crash di un programma o sistema.

Comprendere come gli hacker ideano potenziali exploit e pianificano i loro attacchi è di fondamentale importanza, poiché alla fine può aiutare a sviluppare misure di sicurezza efficaci contro i loro attacchi. Finora la creazione di exploits è stata possibile principalmente per individui con una vasta conoscenza di programmazione, dei protocolli che regolano lo scambio di dati tra dispositivi o sistemi, e dei sistemi operativi.

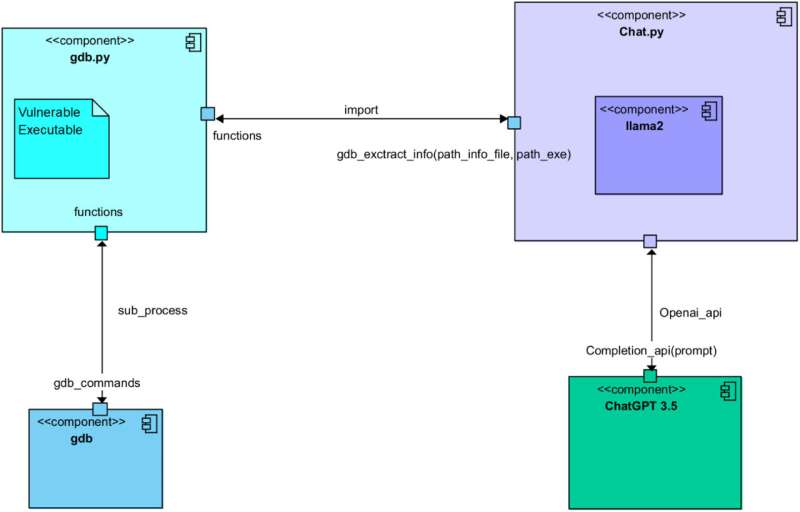

Tuttavia, un recente articolo pubblicato su Computer Networks mostra che questa potrebbe non essere più necessariamente la situazione attuale. Gli exploit potrebbero essere anche generati automaticamente sfruttando modelli di linguaggio di grandi dimensioni (LLM), come il modello alla base della famosa piattaforma di conversazione ChatGPT. In effetti, gli autori del paper sono stati in grado di automatizzare la generazione di exploit attraverso una conversazione accuratamente programmata tra ChatGPT e Llama 2, il LLM open-source sviluppato da Meta.

"Operiamo nel campo della sicurezza informatica, con un approccio offensivo", ha detto Simon Pietro Romano, co-autore senior del paper, a Tech Xplore. "Era nostro interesse capire quanto potessimo arrivare ad utilizzare LLM per facilitare le attività di penetration testing."

Nell'ambito del loro recente studio, Romano e i suoi colleghi hanno avviato una conversazione mirata a generare exploit software tra ChatGPT e Llama 2. Progettando accuratamente i suggerimenti forniti ai due modelli, hanno garantito che i modelli assumessero ruoli differenti e completassero cinque passaggi noti per supportare la creazione di exploit.

Questi passaggi includevano: l'analisi di un programma vulnerabile, l'identificazione di possibili exploit, la pianificazione di un attacco basato su questi exploit, la comprensione del comportamento dei sistemi hardware presi di mira e infine la generazione effettiva del codice exploit.

"Facciamo interagire due LLM diversi per attraversare tutti i passaggi coinvolti nel processo di creazione di un exploit valido per un programma vulnerabile", ha spiegato Romano. "Uno dei due LLM raccoglie informazioni 'contestuali' sul programma vulnerabile e sulla sua configurazione in esecuzione. Chiede quindi all'altro LLM di creare un exploit funzionante. In poche parole, il primo LLM è bravo a fare domande. Il secondo è bravo a scrivere (codice di exploit)."

Finora i ricercatori hanno testato il loro metodo di generazione di exploit basato su LLM solo in un esperimento iniziale. Tuttavia, hanno scoperto che alla fine ha prodotto un codice completamente funzionale per un exploit di overflow di buffer, un attacco che comporta la sovrascrittura dei dati memorizzati da un sistema per alterare il comportamento di programmi specifici.

"Si tratta di uno studio preliminare, ma dimostra chiaramente la fattibilità dell'approccio", ha detto Romano. "Le implicazioni riguardano la possibilità di arrivare a Test di Penetrazione e Valutazione della Vulnerabilità (VAPT) completamente automatizzati."

Lo studio recente di Romano e dei suoi colleghi pone importanti interrogativi sui rischi degli LLM, poiché mostra come gli hacker potrebbero utilizzarli per automatizzare la generazione di exploit. Nei loro prossimi studi, i ricercatori prevedono di continuare a investigare sull'efficacia della strategia di generazione di exploit che hanno ideato per informare lo sviluppo futuro degli LLM, così come l'avanzamento delle misure di sicurezza informatica.

"Stiamo ora esplorando ulteriori percorsi di ricerca nello stesso campo di applicazione", ha aggiunto Romano. "Nello specifico, pensiamo che il proseguimento naturale delle nostre ricerche ricada nel campo del cosiddetto approccio 'agentico', con una supervisione umana minima."

Scritto per te dal nostro autore Ingrid Fadelli, editato da Gaby Clark e verificato da Andrew Zinin - questo articolo è il risultato di un attento lavoro umano. Ci affidiamo ai lettori come te per mantenere viva la giornalismo scientifico indipendente. Se questa notizia è importante per te, per favore considera una donazione (soprattutto mensile). Riceverai un account senza pubblicità come ringraziamento.

Ulteriori informazioni: Uno scambio tra Llama 2 e ChatGPT per la creazione automatizzata di exploit. Computer Networks (2025). DOI: 10.1016/j.comnet.2025.111501.

© 2025 Science X Network

ARTICOLI CORRELATI

× chiudi