Gespräche zwischen LLMs könnten die Erstellung von Exploits automatisieren, zeigt eine Studie.

19. Juli 2025 feature

von Ingrid Fadelli, Phys.org

Mitarbeitender Autor

herausgegeben von Gaby Clark, überprüft von Andrew Zinin

wissenschaftlicher Redakteur

leitender Redakteur

Dieser Artikel wurde gemäß dem Redaktionsprozess und den Richtlinien von Science X überprüft. Redakteure haben die folgenden Merkmale hervorgehoben, um die Glaubwürdigkeit des Inhalts zu gewährleisten:

Faktenüberprüfung

vertrauenswürdige Quelle

Korrektur gelesen

Da Computer und Software immer ausgefeilter werden, müssen Hacker sich schnell an die neuesten Entwicklungen anpassen und neue Strategien zur Planung und Ausführung von Cyberangriffen entwickeln. Eine gängige Strategie, um auf bösartige Weise in Computersysteme einzudringen, wird als Softwareausnutzung bezeichnet.

Wie der Name schon sagt, beinhaltet diese Strategie die Ausnutzung von Fehlern, Schwachstellen oder Mängeln in der Software, um nicht autorisierte Aktionen auszuführen. Diese Aktionen umfassen den Zugriff auf persönliche Benutzerkonten oder Computer, das remote Ausführen von Malware oder spezifischen Befehlen, das Stehlen oder Modifizieren von Benutzerdaten oder das Abstürzen eines Programms oder Systems.

Das Verständnis dafür, wie Hacker potenzielle Ausnutzungen entwickeln und ihre Angriffe planen, ist von größter Bedeutung, da es letztendlich dazu beitragen kann, wirksame Sicherheitsmaßnahmen gegen ihre Angriffe zu entwickeln. Bisher war die Erstellung von Ausnutzungen hauptsächlich Personen möglich, die über umfangreiche Kenntnisse in der Programmierung, den Protokollen für den Austausch von Daten zwischen Geräten oder Systemen und Betriebssystemen verfügen.

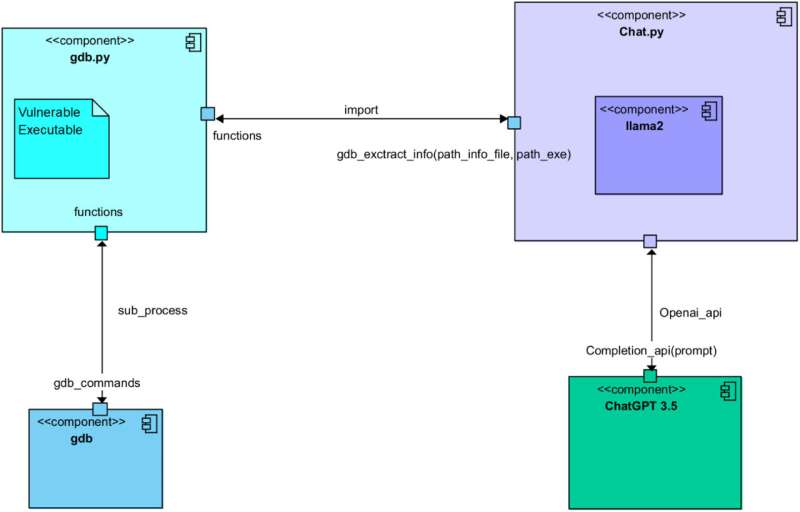

Eine kürzlich in Computer Networks veröffentlichte Arbeit zeigt jedoch, dass dies vielleicht nicht mehr der Fall ist. Ausnutzungen könnten auch automatisch generiert werden, indem große Sprachmodelle (LLMs) genutzt werden, wie das Modell, das der bekannten Konversationsplattform ChatGPT zugrunde liegt. Tatsächlich konnten die Autoren der Arbeit die Erzeugung von Ausnutzungen durch eine sorgfältig geführte Unterhaltung zwischen ChatGPT und Llama 2, dem Open-Source-LLM von Meta, automatisieren.

'Wir arbeiten im Bereich der Cybersicherheit mit einem offensiven Ansatz,' sagte Simon Pietro Romano, Co-Hauptschriftsteller der Arbeit, gegenüber Tech Xplore. 'Wir waren daran interessiert zu verstehen, wie weit wir gehen können, indem wir LLMs einsetzen, um Penetrationstests zu erleichtern.'

Im Rahmen ihrer jüngsten Studie initiierten Romano und seine Kollegen eine Unterhaltung zwischen ChatGPT und Llama 2, um Softwareausnutzungen zu generieren. Durch die sorgfältige Gestaltung der Anregungen, die sie den beiden Modellen zuführten, stellten sie sicher, dass die Modelle verschiedene Rollen übernahmen und fünf verschiedene Schritte abschlossen, die für die Erstellung von Ausnutzungen bekannt sind.

Zu diesen Schritten gehörten: die Analyse eines verwundbaren Programms, die Identifizierung möglicher Ausnutzungen, die Planung eines Angriffs basierend auf diesen Ausnutzungen, das Verständnis des Verhaltens der zielgerichteten Hardwaresysteme und letztendlich die Generierung des tatsächlichen Ausnutzungscodes.

'Wir haben zwei verschiedene LLMs interagieren lassen, um alle Schritte des Prozesses zur Entwicklung einer gültigen Ausnutzung für ein verwundbares Programm zu durchlaufen,' erklärte Romano. 'Eines der beiden LLMs sammelt 'kontextuelle' Informationen über das verwundbare Programm und dessen Laufzeitkonfiguration. Anschließend bittet es das andere LLM, eine funktionierende Ausnutzung zu entwickeln. Im wesentlichen ist das erstere LLM gut darin, Fragen zu stellen. Das letztere ist gut darin, (Ausnutzungs-)Code zu schreiben.'

Bisher haben die Forscher ihre auf LLMs basierende Methode zur Erzeugung von Ausnutzungen nur in einem ersten Experiment getestet. Dennoch stellten sie fest, dass sie letztendlich voll funktionsfähigen Code für eine Pufferüberlaufausnutzung erzeugte, einen Angriff, bei dem Daten überschrieben werden, die von einem System gespeichert sind, um das Verhalten spezifischer Programme zu ändern.

'Dies ist eine vorläufige Studie, die jedoch eindeutig die Machbarkeit des Ansatzes beweist,' sagte Romano. 'Die Implikationen betreffen die Möglichkeit, bei der vollständig automatisierten Durchführung von Penetrationstests und Schwachstellenanalysen (VAPT) anzukommen.'

Die jüngste Studie von Romano und seinen Kollegen wirft wichtige Fragen zu den Risiken von LLMs auf, da sie zeigt, wie Hacker sie nutzen könnten, um die Erzeugung von Ausnutzungen zu automatisieren. In ihren nächsten Studien planen die Forscher, die Wirksamkeit der von ihnen entwickelten Ausnutzungsgenerierungsstrategie weiter zu untersuchen, um die zukünftige Entwicklung von LLMs sowie den Fortschritt von Cybersicherheitsmaßnahmen zu informieren.

'Wir erforschen derzeit weitere Forschungsansätze auf demselben Anwendungsgebiet,' fügte Romano hinzu. 'Konkret fühlen wir, dass die natürliche Fortsetzung unserer Forschung im Bereich des sogenannten 'agentischen' Ansatzes liegt, mit minimaler menschlicher Aufsicht.'

Geschrieben für Sie von unserer Autorin Ingrid Fadelli, bearbeitet von Gaby Clark und von Andrew Zinin überprüft und überarbeitet - dieser Artikel ist das Ergebnis sorgfältiger menschlicher Arbeit. Wir sind auf Leser wie Sie angewiesen, um den unabhängigen Wissenschaftsjournalismus am Leben zu erhalten. Wenn Ihnen diese Berichterstattung wichtig ist, erwägen Sie bitte eine Spende (insbesondere monatlich). Als Dank erhalten Sie ein werbefreies Konto.

Weitere Informationen: Ein Schwätzchen zwischen Llama 2 und ChatGPT zur automatisierten Erstellung von Exploits. Computer Networks (2025). DOI: 10.1016/j.comnet.2025.111501.

© 2025 Science X Network