Conversations between LLMs could automate the creation of exploits, study shows

Le 19 juillet 2025

caractéristique

par Ingrid Fadelli, Phys.org

écrivain contributeur

édité par Gaby Clark, examiné par Andrew Zinin

éditeur scientifique, éditeur principal

Cet article a été examiné selon le processus éditorial et les politiques de Science X. Les éditeurs ont mis en avant les attributs suivants tout en veillant à la crédibilité du contenu :

vérification des faits, source fiable, texte relu

Avec l'avancement des ordinateurs et des logiciels de plus en plus sophistiqués, les hackers doivent s'adapter rapidement aux derniers développements et concevoir de nouvelles stratégies pour planifier et exécuter des cyberattaques. Une stratégie courante pour infiltrer de manière malveillante les systèmes informatiques est connue sous le nom d'exploitation de logiciels.

Comme son nom l'indique, cette stratégie implique l'exploitation de bogues, de vulnérabilités ou de failles dans les logiciels pour exécuter des actions non autorisées. Ces actions comprennent l'accès aux comptes personnels ou à l'ordinateur d'un utilisateur, l'exécution à distance de logiciels malveillants ou de commandes spécifiques, le vol ou la modification des données d'un utilisateur ou le plantage d'un programme ou d'un système.

Comprendre comment les hackers conçoivent des exploits potentiels et planifient leurs attaques est d'une importance capitale, car cela peut finalement aider à développer des mesures de sécurité efficaces contre leurs attaques. Jusqu'à présent, la création d'exploits était principalement possible pour les personnes ayant une connaissance approfondie de la programmation, des protocoles régissant l'échange de données entre appareils ou systèmes, et des systèmes d'exploitation.

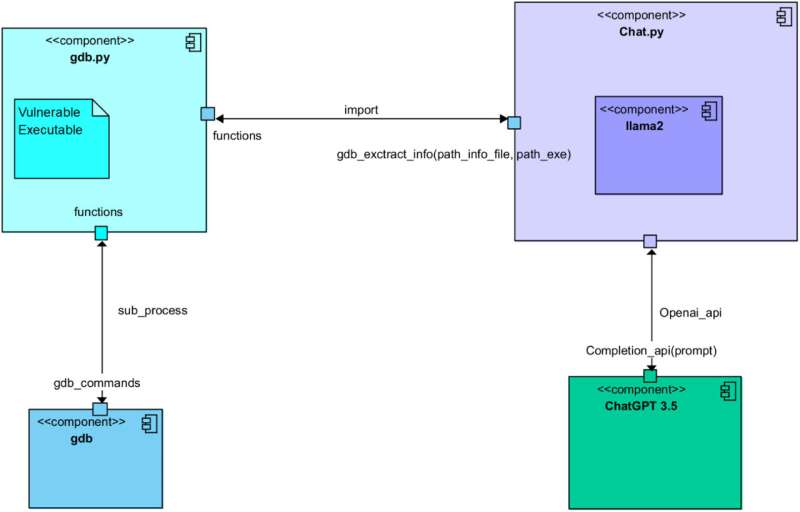

Un article récent publié dans Computer Networks montre cependant que cela pourrait ne plus être le cas. Les exploits pourraient également être générés automatiquement en exploitant de grands modèles de langage (LLM), tels que le modèle sous-jacent de la célèbre plateforme conversationnelle ChatGPT. En fait, les auteurs de l'article ont réussi à automatiser la génération d'exploits via une conversation soigneusement provoquée entre ChatGPT et Llama 2, le LLM open source développé par Meta.

''Nous travaillons dans le domaine de la cybersécurité, avec une approche offensive'', a déclaré Simon Pietro Romano, co-auteur principal de l'article, à Tech Xplore. ''Nous étions intéressés à comprendre dans quelle mesure nous pouvions utiliser les LLM pour faciliter les activités de test de pénétration.''

Dans le cadre de leur récente étude, Romano et ses collègues ont initié une conversation visant à générer des exploits logiciels entre ChatGPT et Llama 2. En soignant les prompts qu'ils ont soumis aux deux modèles, ils ont veillé à ce que les modèles assument différents rôles et accomplissent cinq étapes différentes connues pour soutenir la création d'exploits.

Ces étapes comprenaient : l'analyse d'un programme vulnérable, l'identification d'exploits possibles, la planification d'une attaque basée sur ces exploits, la compréhension du comportement des systèmes matériels ciblés et enfin la génération du code d'exploit réel.

''Nous avons laissé deux LLM différents coopérer afin de passer par toutes les étapes du processus de création d'un exploit valide pour un programme vulnérable'', a expliqué Romano. ''L'un des LLM rassemble des informations 'contextuelles' sur le programme vulnérable et sa configuration en temps d'exécution. Il demande ensuite à l'autre LLM de créer un exploit fonctionnel. En un mot, le premier LLM pose des questions. Le second est bon pour écrire (l'exploit) code.''

Jusqu'à présent, les chercheurs n'ont testé leur méthode de génération d'exploits basée sur les LLM que dans une expérience initiale. Néanmoins, ils ont constaté qu'elle produisait finalement un code entièrement fonctionnel pour un exploit de débordement de mémoire tampon, une attaque qui consiste à écrire des données stockées par un système pour modifier le comportement de programmes spécifiques.

''Il s'agit d'une étude préliminaire, mais elle prouve clairement la faisabilité de l'approche'', a déclaré Romano. ''Les implications concernent la possibilité d'arriver à un test de pénétration et une évaluation des vulnérabilités entièrement automatisés.''

L'étude récente de Romano et de ses collègues soulève d'importantes questions sur les risques des LLM, car elle montre comment les hackers pourraient les utiliser pour automatiser la génération d'exploits. Dans leurs prochaines études, les chercheurs prévoient de continuer à enquêter sur l'efficacité de la stratégie de génération d'exploits qu'ils ont élaborée pour informer le développement futur des LLM, ainsi que l'avancement des mesures de cybersécurité.

''Nous explorons actuellement d'autres voies de recherche dans le même champ d'application'', a ajouté Romano. ''En particulier, nous estimons que le prolongement naturel de notre recherche se situe dans le domaine de l'approche 'agentic', avec une supervision humaine minimale.''

Écrit pour vous par notre auteure Ingrid Fadelli, édité par Gaby Clark, et vérifié par Andrew Zinin - cet article est le résultat d'un travail humain soigneux. Nous comptons sur des lecteurs comme vous pour maintenir en vie un journalisme scientifique indépendant. Si ce rapport est important pour vous, veuillez envisager un don (surtout mensuel). Vous obtiendrez un compte sans publicité en remerciement.

Plus d'informations : Une discussion entre Llama 2 et ChatGPT pour la création automatisée de exploits. Réseaux informatiques (2025). DOI : 10.1016/j.comnet.2025.111501.

© 2025 Science X Network

ARTICLES CONNEXES

× close