Conversaciones entre LLMs podrían automatizar la creación de exploits, muestra un estudio

19 de julio de 2025 función

por Ingrid Fadelli, Phys.org

escritora colaboradora

editado por Gaby Clark, revisado por Andrew Zinin

editor científico

editor principal

Este artículo ha sido revisado de acuerdo con el proceso editorial y las políticas de Science X. Los editores han destacado las siguientes cualidades mientras aseguran la credibilidad del contenido:

verificación de hechos

fuente confiable

corrección de pruebas

A medida que las computadoras y el software se vuelven cada vez más sofisticados, los hackers necesitan adaptarse rápidamente a los últimos desarrollos y elaborar nuevas estrategias para planificar y ejecutar ciberataques. Una estrategia común para infiltrarse maliciosamente en sistemas informáticos se conoce como explotación de software.

Como sugiere su nombre, esta estrategia implica la explotación de errores, vulnerabilidades o fallas en el software para ejecutar acciones no autorizadas. Estas acciones incluyen obtener acceso a las cuentas personales de un usuario o computadora, ejecutar malware o comandos específicos de forma remota, robar o modificar los datos de un usuario o hacer colapsar un programa o sistema.

Comprender cómo los hackers idean posibles exploits y planifican sus ataques es de suma importancia, ya que finalmente puede ayudar a desarrollar medidas de seguridad efectivas contra sus ataques. Hasta ahora, la creación de exploits ha sido principalmente posible para personas con un amplio conocimiento en programación, los protocolos que rigen el intercambio de datos entre dispositivos o sistemas, y sistemas operativos.

Sin embargo, un artículo reciente publicado en Computer Networks muestra que esto podría ya no ser el caso. Los exploits también podrían generarse automáticamente aprovechando modelos de lenguaje grandes (LLMs), como el modelo que subyace a la conocida plataforma conversacional ChatGPT. De hecho, los autores del artículo lograron automatizar la generación de exploits a través de una conversación cuidadosamente promovida entre ChatGPT y Llama 2, el LLM de código abierto desarrollado por Meta.

'Trabajamos en el campo de la ciberseguridad, con un enfoque ofensivo,' dijo Simon Pietro Romano, coautor principal del artículo, a Tech Xplore. 'Nos interesaba entender hasta dónde podíamos llegar utilizando LLMs para facilitar actividades de pruebas de penetración.'

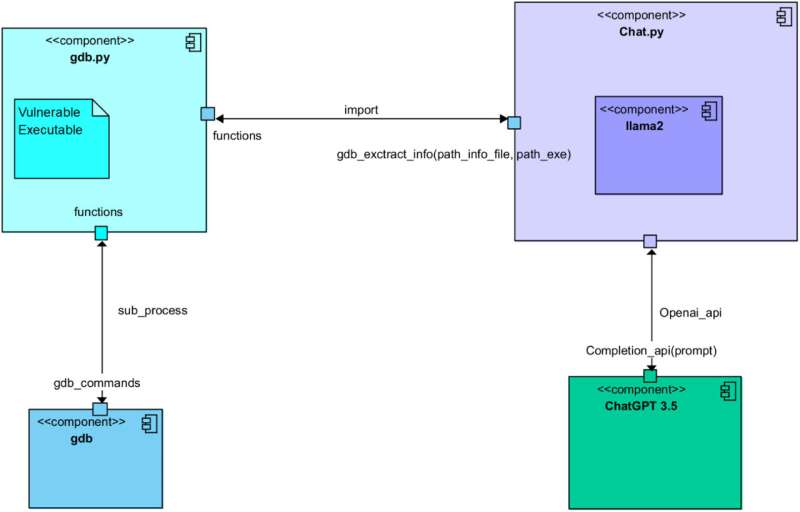

Como parte de su estudio reciente, Romano y sus colegas iniciaron una conversación con el objetivo de generar exploits de software entre ChatGPT y Llama 2. Al diseñar cuidadosamente las promociones que alimentaron a los dos modelos, aseguraron que los modelos asumieran roles diferentes y completaran cinco pasos conocidos por apoyar la creación de exploits.

Estos pasos incluyeron: el análisis de un programa vulnerable, la identificación de posibles exploits, la planificación de un ataque basado en estos exploits, comprender el comportamiento de los sistemas de hardware objetivo y, en última instancia, generar el código de exploit real.

'Permitimos que dos LLMs diferentes interoperaran para lograr todos los pasos involucrados en el proceso de elaborar un exploit válido para un programa vulnerable,' explicó Romano. 'Uno de los dos LLMs recopila información 'contextual' sobre el programa vulnerable y su configuración en tiempo de ejecución. Luego, le pide al otro LLM que elabore un exploit funcional. En resumen, el primer LLM es bueno haciendo preguntas. El segundo es bueno escribiendo (exploit) código.'

Hasta ahora, los investigadores solo han probado su método de generación de exploits basado en LLM en un experimento inicial. Sin embargo, encontraron que al final produjo un código completamente funcional para un exploit de desbordamiento de búfer, un ataque que implica sobrescribir datos almacenados por un sistema para alterar el comportamiento de programas específicos.

'Este es un estudio preliminar, pero claramente demuestra la viabilidad del enfoque,' dijo Romano. 'Las implicaciones están relacionadas con la posibilidad de llegar a Pruebas de Penetración y Evaluación de Vulnerabilidades totalmente automatizadas (VAPT)'

El estudio reciente de Romano y sus colegas plantea importantes preguntas sobre los riesgos de los LLMs, ya que muestra cómo los hackers podrían usarlos para automatizar la generación de exploits. En sus próximos estudios, los investigadores planean seguir investigando la eficacia de la estrategia de generación de exploits que idearon para informar el futuro desarrollo de LLMs, así como el avance de las medidas de ciberseguridad.

'Ahora estamos explorando más vías de investigación en el mismo campo de aplicación,' agregó Romano. 'Específicamente, sentimos que la continuación natural de nuestra investigación cae en el campo del denominado enfoque 'agentic', con una supervisión humana mínima.'

Escrito para ti por nuestra autora Ingrid Fadelli, editado por Gaby Clark y verificado por Andrew Zinin—este artículo es el resultado de un trabajo humano cuidadoso. Dependemos de lectores como tú para mantener viva la independencia del periodismo científico. Si esta información es importante para ti, por favor considera hacer una donación (especialmente mensual). Obtendrás una cuenta sin anuncios como agradecimiento.

Más información: Una conversación entre Llama 2 y ChatGPT para la creación automatizada de exploits. Redes de Computadoras (2025). DOI: 10.1016/j.comnet.2025.111501.

© 2025 Science X Network