Disegno in tempo reale simile all'umanità da parte di un robot umanoide

24 febbraio 2024 caratteristica

Questo articolo è stato revisionato secondo il processo editoriale e le politiche di Science X. Gli editori hanno evidenziato i seguenti attributi garantendo la credibilità dei contenuti:

- verifica dei fatti

- preprint

- fonte affidabile

- corretto

di Ingrid Fadelli , Tech Xplore

Il rapido avanzamento degli algoritmi di deep learning e dei modelli generativi ha permesso la produzione automatizzata di contenuti artistici AI sempre più sorprendenti. Gran parte di questa arte generata dall'AI, tuttavia, è creata da algoritmi e modelli computazionali, piuttosto che da robot fisici.

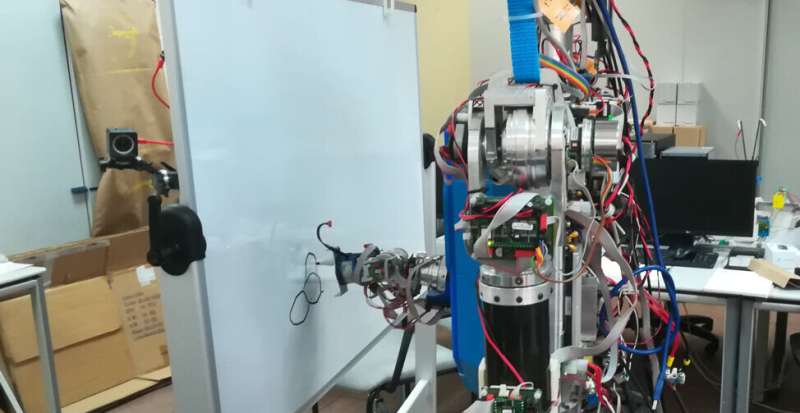

Ricercatori presso l'Universidad Complutense de Madrid (UCM) e l'Universidad Carlos III de Madrid (UC3M) hanno recentemente sviluppato un modello basato sul deep learning che permette a un robot umanoide di schizzare immagini, in modo simile a come farebbe un artista umano. Il loro articolo, pubblicato su Cognitive Systems Research, offre una dimostrazione straordinaria di come i robot potrebbero essere attivamente coinvolti nei processi creativi.

'La nostra idea era quella di proporre un'applicazione robotica che potesse attirare la comunità scientifica e il pubblico in generale,' ha detto Raúl Fernandez-Fernandez, co-autore dell'articolo, a Tech Xplore. 'Abbiamo pensato a un compito che potesse essere scioccante vedere eseguito da un robot, ed è così che ci è venuto in mente il concetto di fare arte con un robot umanoide.'

La maggior parte dei sistemi robotici esistenti progettati per produrre schizzi o dipinti funzionano essenzialmente come stampanti, riproducendo immagini generate in precedenza da un algoritmo. Fernandez-Fernandez e i suoi colleghi, d'altra parte, desideravano creare un robot che sfruttasse le tecniche di apprendimento profondo per creare schizzi tratto dopo tratto, simili a come li disegnerebbero gli esseri umani.

'L'obiettivo del nostro studio non era quello di creare un'applicazione robotica per dipingere che potesse generare dipinti complessi, ma piuttosto di creare un robusto robot pittore fisico,' ha detto Fernandez-Fernandez. 'Volevamo migliorare la fase di controllo del robot delle applicazioni di pittura.'

Negli ultimi anni, Fernandez-Fernandez e i suoi colleghi hanno cercato di ideare algoritmi avanzati ed efficienti per pianificare le azioni dei robot creativi. Il loro nuovo articolo si basa su questi recenti sforzi di ricerca, combinando approcci che hanno trovato particolarmente promettenti.

'Questo lavoro è stato ispirato da due lavori chiave precedenti,' ha detto Fernandez-Fernandez. 'Il primo di questi è uno dei nostri precedenti sforzi di ricerca, in cui abbiamo esplorato il potenziale del dataset Quick Draw! per addestrare robot pittori. Il secondo lavoro ha introdotto il Deep-Q-Learning come metodo per eseguire traiettorie complesse che potrebbero includere caratteristiche complesse come emozioni.'

Il nuovo sistema di schizzi robotici presentato dai ricercatori si basa su un telaio Deep-Q-Learning introdotto in un precedente articolo di Zhou e colleghi pubblicato su arXiv. Fernandez-Fernandez e i suoi colleghi hanno migliorato questo telaio per pianificare attentamente le azioni dei robot, consentendo loro di completare compiti manuali complessi in una vasta gamma di ambienti.

'La rete neurale è divisa in tre parti che possono essere viste come tre reti diverse interconnesse,' ha spiegato Fernandez-Fernandez. 'La rete globale estrae le caratteristiche di alto livello dell'intero tela. La rete locale estrae le caratteristiche di basso livello intorno alla posizione del dipinto. La rete di output prende in input le caratteristiche estratte dai livelli convoluzionali (dalle reti globali e locali) per generare le posizioni di dipinto successive.'

Fernandez-Fernandez e i suoi collaboratori hanno inoltre informato il loro modello tramite due canali aggiuntivi che forniscono informazioni relative alla distanza e agli strumenti di pittura (cioè, la posizione dell'utensile rispetto al telaio). Collettivamente, tutte queste caratteristiche hanno guidato l'addestramento della loro rete, potenziandone le capacità di schizzo. Per migliorare ulteriormente le capacità di pittura simili a quelle umane del loro sistema, i ricercatori hanno introdotto anche una fase di pre-addestramento basata su un cosiddetto generatore di tratti casuali.

'Utilizziamo il double Q-learning per evitare il problema della sovrastima e una funzione di ricompensa personalizzata per il suo addestramento,' ha detto Fernandez-Fernandez. 'Inoltre, abbiamo introdotto una rete di classificazione schizzi aggiuntiva per estrarre le caratteristiche di alto livello dello schizzo e utilizzare il suo output come ricompensa nelle ultime fasi di un'epoca di pittura. Questa rete fornisce una certa flessibilità alla pittura poiché la ricompensa generata da essa non dipende dal telaio di riferimento ma dalla categoria.'

As they were trying to automate sketching using a physical robot, the researchers had to also devise a strategy to translate the distances and positions observed in AI-generated images into a canvas in the real world. To achieve this, they generated a discretized virtual space within the physical canvas, in which the robot could move and directly translate the painting positions provided by the model.

'I think the most relevant achievement of this work is the introduction of advanced control algorithms within a real robot painting application,' Fernandez-Fernandez said. 'With this work, we have demonstrated that the control step of painting robot applications can be improved with the introduction of these algorithms. We believe that DQN frameworks have the capability and level of abstraction to achieve original and high-level applications out of the scope of classical problems.'

The recent work by this team of researchers is a fascinating example of how robots could create art in the real world, via actions that more closely resemble those of human artists. Fernandez-Fernandez and his colleagues hope that the deep learning-based model they developed will inspire further studies, potentially contributing to the introduction of control policies that allow robots to tackle increasingly complex tasks.

'In this line of work, we have developed a framework using Deep Q-Learning to extract the emotions of a human demonstrator and transfer it to a robot,' Fernandez-Fernandez added. 'In this recent paper, we take advantage of the feature extraction capabilities of DQN networks to treat emotions as a feature that can be optimized and defined within the reward of a standard robot task and results are quite impressive.

'In future works, we aim to introduce similar ideas that enhance robot control applications beyond classical robot control problems.'

© 2024 Science X Network