Dibujo en tiempo real similar al humano por un robot humanoide.

24 de febrero de 2024 función

Este artículo ha sido revisado de acuerdo con el proceso editorial y las políticas de Science X. Los editores han destacado los siguientes atributos mientras aseguran la credibilidad del contenido:

- verificado por hechos

- preprint

- fuente confiable

- corregido

por Ingrid Fadelli , Tech Xplore

El rápido avance de los algoritmos de aprendizaje profundo y los modelos generativos ha permitido la producción automatizada de contenido artístico generado por IA cada vez más impactante. Sin embargo, la mayoría de esta arte generada por IA es creada por algoritmos y modelos computacionales, en lugar de por robots físicos.

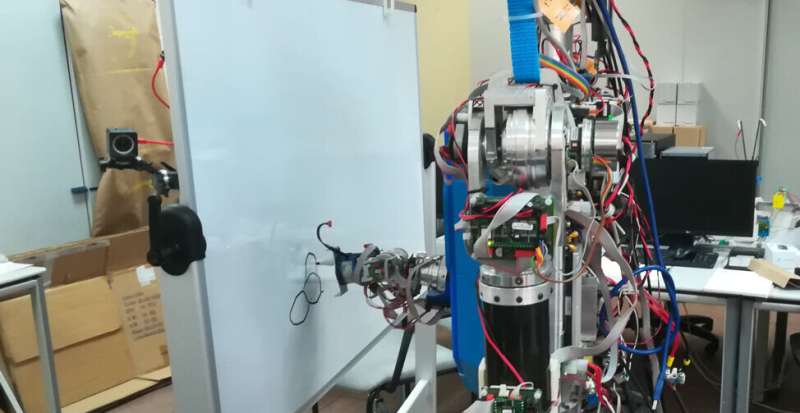

Investigadores de la Universidad Complutense de Madrid (UCM) y la Universidad Carlos III de Madrid (UC3M) desarrollaron recientemente un modelo basado en aprendizaje profundo que permite a un robot humanoide esbozar imágenes, de manera similar a como lo haría un artista humano. Su artículo, publicado en Cognitive Systems Research, ofrece una demostración notable de cómo los robots podrían participar activamente en procesos creativos.

'Nuestra idea era proponer una aplicación de robot que pudiera atraer a la comunidad científica y al público en general,' dijo Raúl Fernández-Fernández, coautor del artículo, a Tech Xplore. 'Pensamos en una tarea que pudiera ser impactante ver a un robot realizando, y así surgió el concepto de hacer arte con un robot humanoide.'

La mayoría de los sistemas robóticos existentes diseñados para producir bocetos o pinturas funcionan esencialmente como impresoras, reproduciendo imágenes que fueron generadas previamente por un algoritmo. Fernández-Fernández y sus colegas, por otro lado, deseaban crear un robot que aprovechara técnicas de aprendizaje reforzado profundo para crear bocetos trazo a trazo, de manera similar a como lo harían los humanos al dibujarlos.

'El objetivo de nuestro estudio no era hacer una aplicación de robot pintor que pudiera generar cuadros complejos, sino más bien crear un robot pintor físico robusto,' dijo Fernández-Fernández. 'Queríamos mejorar la etapa de control del robot en las aplicaciones de pintura con robot.'

En los últimos años, Fernández-Fernández y sus colegas han estado intentando idear algoritmos avanzados y eficientes para planificar las acciones de robots creativos. Su nuevo artículo se basa en estos esfuerzos de investigación recientes, combinando enfoques que encontraron particularmente prometedores.

'Este trabajo se inspiró en dos trabajos previos clave,' dijo Fernández-Fernández. 'El primero de estos es uno de nuestros esfuerzos de investigación anteriores, donde exploramos el potencial del conjunto de datos de Quick Draw! para entrenar a pintores robóticos. El segundo trabajo introdujo Deep-Q-Learning como una forma de realizar trayectorias complejas que podrían incluir características complejas como emociones.'

El nuevo sistema de bocetos robóticos presentado por los investigadores se basa en un marco de Deep-Q-Learning introducido por primera vez en un artículo anterior por Zhou y colegas publicado en arXiv. Fernández-Fernández y sus colegas mejoraron este marco para planificar cuidadosamente las acciones de los robots, permitiéndoles completar tareas manuales complejas en una amplia variedad de entornos.

'La red neuronal se divide en tres partes que pueden verse como tres redes diferentes interconectadas,' explicó Fernández-Fernández. 'La red global extrae las características de alto nivel de todo el lienzo. La red local extrae características de bajo nivel alrededor de la posición del dibujo. La red de salida toma como entrada las características extraídas por las capas convolucionales (de las redes global y local) para generar las siguientes posiciones de dibujo.'

Fernández-Fernández y sus colaboradores también informaron a su modelo a través de dos canales adicionales que proporcionan información relacionada con la distancia y la herramienta de pintura (es decir, la posición de la herramienta con respecto al lienzo). Colectivamente, todas estas características guiaron el entrenamiento de su red, mejorando sus habilidades de bocetado. Para mejorar aún más las habilidades de pintura similares a las de los humanos de su sistema, los investigadores también introdujeron un paso de pre-entrenamiento basado en un generador de trazos aleatorios.

'Usamos el aprendizaje Q doble para evitar el problema de sobreestimación y una función de recompensa personalizada para su entrenamiento,' dijo Fernández-Fernández. 'Además de esto, introdujimos una red de clasificación de bocetos adicional para extraer las características de alto nivel del boceto y usar su salida como recompensa en los últimos pasos de una época de pintura. Esta red proporciona cierta flexibilidad a la pintura ya que la recompensa generada por ella no depende del lienzo de referencia sino de la categoría.'

As they were trying to automate sketching using a physical robot, the researchers had to also devise a strategy to translate the distances and positions observed in AI-generated images into a canvas in the real world. To achieve this, they generated a discretized virtual space within the physical canvas, in which the robot could move and directly translate the painting positions provided by the model.

'I think the most relevant achievement of this work is the introduction of advanced control algorithms within a real robot painting application,' Fernandez-Fernandez said. 'With this work, we have demonstrated that the control step of painting robot applications can be improved with the introduction of these algorithms. We believe that DQN frameworks have the capability and level of abstraction to achieve original and high-level applications out of the scope of classical problems.'

The recent work by this team of researchers is a fascinating example of how robots could create art in the real world, via actions that more closely resemble those of human artists. Fernandez-Fernandez and his colleagues hope that the deep learning-based model they developed will inspire further studies, potentially contributing to the introduction of control policies that allow robots to tackle increasingly complex tasks.

'In this line of work, we have developed a framework using Deep Q-Learning to extract the emotions of a human demonstrator and transfer it to a robot,' Fernandez-Fernandez added. 'In this recent paper, we take advantage of the feature extraction capabilities of DQN networks to treat emotions as a feature that can be optimized and defined within the reward of a standard robot task and results are quite impressive.

'In future works, we aim to introduce similar ideas that enhance robot control applications beyond classical robot control problems.'

© 2024 Science X Network