Menschlich anmutende Echtzeit-Skizzierung durch einen humanoiden Roboter

24. Februar 2024 Feature

Dieser Artikel wurde gemäß dem Redaktionsprozess und den Richtlinien von Science X überprüft. Die Herausgeber haben die folgenden Merkmale hervorgehoben, während sie die Glaubwürdigkeit des Inhalts sicherstellten:

- Faktencheck

- Preprint

- Vertrauenswürdige Quelle

- Korrekturgelesen

Von Ingrid Fadelli, Tech Xplore

Der rasante Fortschritt von Deep-Learning-Algorithmen und generativen Modellen hat die automatisierte Erstellung von immer beeindruckenderen KI-generierten künstlerischen Inhalten ermöglicht. Die meisten dieser KI-generierten Kunstwerke werden jedoch von Algorithmen und Rechenmodellen erstellt, nicht von physischen Robotern.

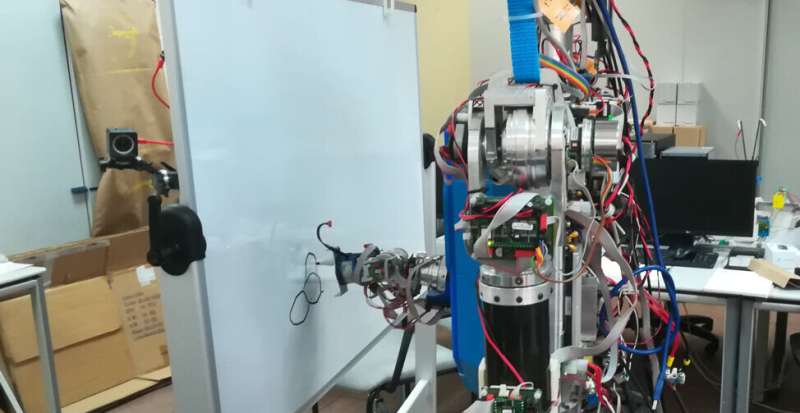

Forscher der Universidad Complutense de Madrid (UCM) und der Universidad Carlos III de Madrid (UC3M) haben kürzlich ein auf Deep Learning basierendes Modell entwickelt, das es einem humanoiden Roboter ermöglicht, Bilder zu skizzieren, ähnlich wie es ein menschlicher Künstler tun würde. Ihre Arbeit, veröffentlicht in Cognitive Systems Research, bietet eine bemerkenswerte Demonstration darüber, wie Roboter aktiv an kreativen Prozessen teilnehmen könnten.

"Unsere Idee war, eine Roboteranwendung vorzuschlagen, die die wissenschaftliche Gemeinschaft und die allgemeine Öffentlichkeit ansprechen könnte", sagte Raúl Fernandez-Fernandez, Co-Autor der Studie, gegenüber Tech Xplore. "Wir dachten über eine Aufgabe nach, die schockierend wäre, einen Roboter dabei zu sehen, und so kam uns der Gedanke, mit einem humanoiden Roboter Kunst zu schaffen."

Die meisten vorhandenen Robotersysteme, die dazu entwickelt wurden, Skizzen oder Gemälde zu erstellen, funktionieren im Grunde wie Drucker, indem sie Bilder reproduzieren, die zuvor von einem Algorithmus generiert wurden. Fernandez-Fernandez und seine Kollegen wollten hingegen einen Roboter schaffen, der Deep-Reinforcement-Learning-Techniken nutzt, um Skizzen Strich für Strich zu erzeugen, ähnlich wie es Menschen tun würden.

"Unser Ziel war es nicht, einen Malroboter zu entwickeln, der komplexe Gemälde erstellen könnte, sondern vielmehr einen robusten physischen Roboter-Maler zu schaffen", sagte Fernandez-Fernandez. "Wir wollten die Robotersteuerungsstufe von Malroboter-Anwendungen verbessern."

In den letzten Jahren haben Fernandez-Fernandez und seine Kollegen versucht, fortschrittliche und effiziente Algorithmen zu entwickeln, um die Aktionen von kreativen Robotern zu planen. Ihre neue Arbeit baut auf diesen jüngsten Forschungsbemühungen auf und kombiniert Ansätze, die sie als besonders vielversprechend empfanden.

"Diese Arbeit wurde von zwei früheren Schlüsselarbeiten inspiriert", sagte Fernandez-Fernandez. "Die erste davon ist eine unserer früheren Forschungsanstrengungen, bei der wir das Potenzial des Quick Draw! Dataset für das Training von robotischen Malern untersucht haben. Das zweite Werk führte Deep-Q-Learning als Möglichkeit ein, komplexe Trajektorien auszuführen, die komplexe Merkmale wie Emotionen enthalten könnten."

Das neue von den Forschern vorgestellte robotische Skizziersystem basiert auf einem Deep-Q-Learning-Framework, das zuvor in einer Arbeit von Zhou und Kollegen auf arXiv eingeführt wurde. Fernandez-Fernandez und seine Kollegen verbesserten dieses Framework, um die Aktionen von Robotern sorgfältig zu planen und es ihnen zu ermöglichen, komplexe manuelle Aufgaben in einer Vielzahl von Umgebungen zu bewältigen.

"Das neuronale Netzwerk ist in drei Teile unterteilt, die als drei verschiedene miteinander verbundene Netzwerke betrachtet werden können", erklärte Fernandez-Fernandez. "Das globale Netzwerk extrahiert die hochrangigen Merkmale der gesamten Leinwand. Das lokale Netzwerk extrahiert niedrigrangige Merkmale um die Position des Gemäldes. Das Ausgabennetzwerk nimmt die von den Faltungsschichten extrahierten Merkmale (aus den globalen und lokalen Netzwerken) als Eingabe auf, um die nächsten Malpositionen zu erzeugen."

Fernandez-Fernandez und seine Mitarbeiter informierten ihr Modell auch über zwei zusätzliche Kanäle, die distanzbezogene und Malwerkzeuginformationen bereitstellen (d.h. die Position des Werkzeugs zur Leinwand). All diese Merkmale zusammen leiteten das Training ihres Netzwerks und verbesserten seine Skizzierfertigkeiten. Um die menschenähnlichen Malergestaltungsfähigkeiten ihres Systems weiter zu verbessern, führten die Forscher auch einen Pre-Training-Schritt ein, der auf einem sogenannten Zufallsstrichgenerator basiert.

"Wir verwenden Double-Q-Learning, um das Überbewertungsproblem zu vermeiden, und eine benutzerdefinierte Belohnungsfunktion für das Training", sagte Fernandez-Fernandez. "Zusätzlich dazu haben wir ein zusätzliches Skizzierungsklassifikationsnetzwerk eingeführt, um die hochrangigen Merkmale der Skizze zu extrahieren und dessen Ausgabe als Belohnung in den letzten Schritten einer Mal-Epoche zu verwenden. Dieses Netzwerk bietet dem Malereiprozess etwas Flexibilität, da die von ihm generierte Belohnung nicht von der Referenzleinwand abhängt, sondern von der Kategorie."

As they were trying to automate sketching using a physical robot, the researchers had to also devise a strategy to translate the distances and positions observed in AI-generated images into a canvas in the real world. To achieve this, they generated a discretized virtual space within the physical canvas, in which the robot could move and directly translate the painting positions provided by the model.

'I think the most relevant achievement of this work is the introduction of advanced control algorithms within a real robot painting application,' Fernandez-Fernandez said. 'With this work, we have demonstrated that the control step of painting robot applications can be improved with the introduction of these algorithms. We believe that DQN frameworks have the capability and level of abstraction to achieve original and high-level applications out of the scope of classical problems.'

The recent work by this team of researchers is a fascinating example of how robots could create art in the real world, via actions that more closely resemble those of human artists. Fernandez-Fernandez and his colleagues hope that the deep learning-based model they developed will inspire further studies, potentially contributing to the introduction of control policies that allow robots to tackle increasingly complex tasks.

'In this line of work, we have developed a framework using Deep Q-Learning to extract the emotions of a human demonstrator and transfer it to a robot,' Fernandez-Fernandez added. 'In this recent paper, we take advantage of the feature extraction capabilities of DQN networks to treat emotions as a feature that can be optimized and defined within the reward of a standard robot task and results are quite impressive.

'In future works, we aim to introduce similar ideas that enhance robot control applications beyond classical robot control problems.'

© 2024 Science X Network