Esquisse en temps réel ressemblant à l'humain par un robot humanoïde

Article du 24 février 2024

Cet article a été révisé conformément au processus éditorial et aux politiques de Science X. Les éditeurs ont mis en avant les attributs suivants tout en garantissant la crédibilité du contenu :

- faits vérifiés

- préimpression

- source fiable

- relire

par Ingrid Fadelli , Tech Xplore

Les progrès rapides des algorithmes d’apprentissage profond et des modèles génératifs ont permis la production automatisée de contenus artistiques générés par l’IA de plus en plus frappants. Cependant, la majeure partie de cet art généré par l’IA est créée par des algorithmes et des modèles informatiques, plutôt que par des robots physiques.

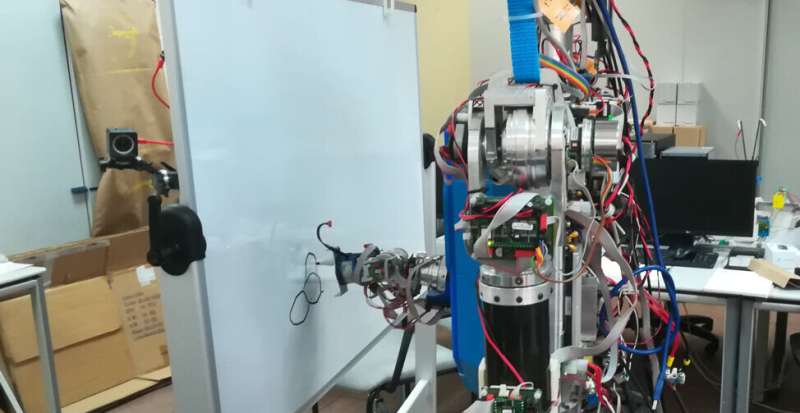

Des chercheurs de l’Université Complutense de Madrid (UCM) et de l’Université Carlos III de Madrid (UC3M) ont récemment développé un modèle basé sur l’apprentissage profond qui permet à un robot humanoïde de dessiner des images, de la même manière qu’un artiste humain. Leur article, publié dans Cognitive Systems Research, offre une démonstration remarquable de la manière dont les robots pourraient s’engager activement dans des processus créatifs.

"Notre idée était de proposer une application robotique susceptible d'attirer la communauté scientifique et le grand public", a déclaré Raúl Fernandez-Fernandez, co-auteur de l'article, à Tech Xplore. "Nous avons réfléchi à une tâche qui pourrait être choquante de voir un robot accomplir, et c'est ainsi que l'idée de faire de l'art avec un robot humanoïde nous est venue."

La plupart des systèmes robotiques existants conçus pour produire des croquis ou des peintures fonctionnent essentiellement comme des imprimantes, reproduisant des images précédemment générées par un algorithme. Fernandez-Fernandez et ses collègues, quant à eux, souhaitaient créer un robot qui exploite des techniques d'apprentissage par renforcement profond pour créer des croquis trait par trait, semblables à la façon dont les humains les dessineraient.

"Le but de notre étude n'était pas de créer une application robotique de peinture capable de générer des peintures complexes, mais plutôt de créer un robot peintre physique robuste", a déclaré Fernandez-Fernandez. «Nous voulions améliorer l'étape de contrôle du robot dans les applications de peinture robotique.»

Au cours des dernières années, Fernandez-Fernandez et ses collègues ont tenté de concevoir des algorithmes avancés et efficaces pour planifier les actions des robots créatifs. Leur nouvel article s’appuie sur ces efforts de recherche récents, combinant des approches qu’ils ont jugées particulièrement prometteuses.

"Ce travail s'inspire de deux travaux antérieurs clés", a déclaré Fernandez-Fernandez. « Le premier d'entre eux est l'un de nos efforts de recherche précédents, dans lequel nous avons exploré le potentiel du Quick Draw ! L'ensemble de données fonctionne pour la formation des peintres robotisés. Le deuxième travail a présenté le Deep-Q-Learning comme un moyen d'effectuer des trajectoires complexes pouvant inclure des caractéristiques complexes telles que les émotions.

Le nouveau système de dessin robotique présenté par les chercheurs est basé sur un cadre Deep-Q-Learning introduit pour la première fois dans un article précédent de Zhou et ses collègues publié sur arXiv. Fernandez-Fernandez et ses collègues ont amélioré ce cadre pour planifier soigneusement les actions des robots, leur permettant ainsi d'effectuer des tâches manuelles complexes dans un large éventail d'environnements.

"Le réseau neuronal est divisé en trois parties qui peuvent être considérées comme trois réseaux différents interconnectés", a expliqué Fernandez-Fernandez. « Le réseau mondial extrait les fonctionnalités de haut niveau du canevas complet. Le réseau local extrait les caractéristiques de bas niveau autour de la position de peinture. Le réseau de sortie prend en entrée les caractéristiques extraites par les couches convolutives (des réseaux globaux et locaux) pour générer les prochaines positions de peinture.

Fernandez-Fernandez et ses collaborateurs ont également informé leur modèle via deux canaux supplémentaires qui fournissent des informations relatives à la distance et à l'outil de peinture (c'est-à-dire la position de l'outil par rapport à la toile). Collectivement, toutes ces fonctionnalités ont guidé la formation de leur réseau, améliorant ainsi ses compétences en matière de dessin. Pour améliorer encore les compétences de peinture de leur système, les chercheurs ont également introduit une étape de pré-formation basée sur un générateur de traits aléatoires.

"Nous utilisons le double Q-learning pour éviter le problème de surestimation et une fonction de récompense personnalisée pour sa formation", a déclaré Fernandez-Fernandez. «En plus de cela, nous avons introduit un réseau supplémentaire de classification des croquis pour extraire les caractéristiques de haut niveau du croquis et utiliser son résultat comme récompense dans les dernières étapes d'une époque de peinture.» Ce réseau apporte une certaine flexibilité au tableau puisque la récompense qu'il génère ne dépend pas de la toile de référence mais de la catégorie.

Alors qu’ils tentaient d’automatiser le dessin à l’aide d’un robot physique, les chercheurs ont également dû concevoir une stratégie pour traduire les distances et les positions observées dans les images générées par l’IA en une toile dans le monde réel. Pour y parvenir, ils ont généré un espace virtuel discrétisé au sein de la toile physique, dans lequel le robot pouvait se déplacer et traduire directement les positions de peinture fournies par le modèle.

"Je pense que la réalisation la plus importante de ce travail est l'introduction d'algorithmes de contrôle avancés dans une véritable application de peinture robotisée", a déclaré Fernandez-Fernandez. «Grâce à ce travail, nous avons démontré que l'étape de contrôle des applications de robots de peinture peut être améliorée grâce à l'introduction de ces algorithmes.» Nous pensons que les frameworks DQN ont la capacité et le niveau d'abstraction nécessaires pour réaliser des applications originales et de haut niveau hors du cadre des problèmes classiques.

Les travaux récents de cette équipe de chercheurs constituent un exemple fascinant de la manière dont les robots pourraient créer de l’art dans le monde réel, via des actions qui ressemblent davantage à celles des artistes humains. Fernandez-Fernandez et ses collègues espèrent que le modèle basé sur l’apprentissage profond qu’ils ont développé inspirera d’autres études, contribuant potentiellement à l’introduction de politiques de contrôle permettant aux robots d’accomplir des tâches de plus en plus complexes.

"Dans cette ligne de travail, nous avons développé un cadre utilisant Deep Q-Learning pour extraire les émotions d'un démonstrateur humain et les transférer à un robot", a ajouté Fernandez-Fernandez. «Dans cet article récent, nous profitons des capacités d'extraction de caractéristiques des réseaux DQN pour traiter les émotions comme une caractéristique qui peut être optimisée et définie dans le cadre de la récompense d'une tâche robot standard et les résultats sont assez impressionnants.»

"Dans les travaux futurs, nous visons à introduire des idées similaires qui améliorent les applications de contrôle de robot au-delà des problèmes classiques de contrôle de robot."

© 2024 Réseau Science X