Probando un modelo de aprendizaje profundo no supervisado para la imitación de movimientos humanos por parte de un robot

10 de marzo de 2024

Este artículo ha sido revisado de acuerdo con el proceso editorial y las políticas de Science X. Los editores han destacado los siguientes atributos mientras aseguran la credibilidad del contenido:

- verificación de hechos

- preprint

- fuente confiable

corregido por Ingrid Fadelli, Tech Xplore

Los robots que pueden imitar de cerca las acciones y movimientos de los humanos en tiempo real podrían ser increíblemente útiles, ya que podrían aprender a completar tareas cotidianas de formas específicas sin necesidad de ser ampliamente preprogramados en estas tareas. Si bien las técnicas para permitir el aprendizaje por imitación han mejorado considerablemente en los últimos años, su rendimiento a menudo se ve obstaculizado por la falta de correspondencia entre el cuerpo de un robot y el de su usuario humano.

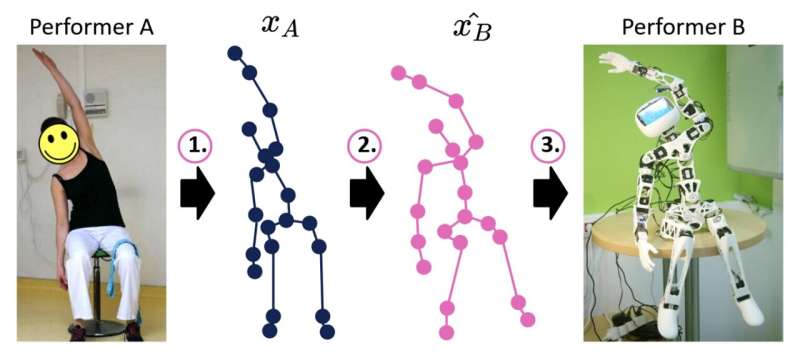

Investigadores de U2IS, ENSTA Paris recientemente presentaron un nuevo modelo basado en deep learning que podría mejorar las capacidades de imitación del movimiento de sistemas robóticos humanoides. Este modelo, presentado en un artículo prepublicado en arXiv, aborda la imitación del movimiento como tres pasos distintos, diseñados para reducir los problemas de correspondencia entre humanos y robots reportados en el pasado.

'Este trabajo de investigación en etapa temprana tiene como objetivo mejorar la imitación humano-robot en línea mediante la traducción de secuencias de posiciones conjuntas del dominio de movimientos humanos a un dominio de movimientos alcanzables por un robot dado, limitado así por su corporalidad,' escribieron Louis Annabi, Ziqi Ma y Sao Mai Nguyen en su artículo. 'Aprovechando las capacidades de generalización de los métodos de deep learning, abordamos este problema proponiendo un modelo de red neuronal codificador-decodificador que realiza una traducción de dominio a dominio.'

El modelo desarrollado por Annabi, Ma y Nguyen separa el proceso de imitación humano-robot en tres pasos clave, a saber, estimación de postura, reorientación de movimiento y control de robot. En primer lugar, utiliza algoritmos de estimación de postura para predecir secuencias de posiciones de articulaciones de esqueleto que fundamentan los movimientos demostrados por agentes humanos.

Posteriormente, el modelo traduce esta secuencia predicha de posiciones de articulaciones de esqueleto en posiciones de articulaciones similares que pueden ser producidas de manera realista por el cuerpo del robot. Finalmente, estas secuencias traducidas se utilizan para planificar los movimientos del robot, lo que teóricamente resulta en movimientos dinámicos que podrían ayudar al robot a realizar la tarea en cuestión.

'Para entrenar un modelo así, se podrían utilizar pares de movimientos asociados de robot y humano, sin embargo, estos datos emparejados son extremadamente raros en la práctica y tediosos de recolectar,' escribieron los investigadores en su artículo. 'Por tanto, recurrimos a métodos de deep learning para la traducción de dominio a dominio no emparejados, que adaptamos para realizar la imitación humano-robot.'

Annabi, Ma y Nguyen evaluaron el rendimiento de su modelo en una serie de pruebas preliminares, comparándolo con un método más simple para reproducir orientaciones conjuntas que no se basa en deep learning. Su modelo no logró los resultados que esperaban, lo que sugiere que los métodos actuales de deep learning pueden no ser capaces de reorientar con éxito los movimientos en tiempo real.

Los investigadores ahora planean realizar más experimentos para identificar posibles problemas con su enfoque, para que puedan abordarlos y adaptar el modelo para mejorar su rendimiento. Hasta el momento, los hallazgos del equipo sugieren que si bien las técnicas de deep learning no supervisadas pueden utilizarse para permitir la imitación en robots, su rendimiento aún no es lo suficientemente bueno como para desplegarse en robots reales.

'El trabajo futuro extenderá el estudio actual en tres direcciones: Investigar más a fondo el fracaso del método actual, como se explica en la última sección, crear un conjunto de datos de movimientos emparejados de imitación humano-humano o robot-humano y mejorar la arquitectura del modelo para obtener predicciones de reorientación más precisas,' concluyen los investigadores en su artículo.

© 2024 Science X Network