Test eines unüberwachten tiefen Lernmodells für die Roboterimitation menschlicher Bewegungen

10. März 2024 Feature

Dieser Artikel wurde gemäß dem Redaktionsprozess und den Richtlinien von Science X überprüft. Die Herausgeber haben die folgenden Merkmale hervorgehoben, während sie die Glaubwürdigkeit des Inhalts sicherstellten:

- Fakten-Check

- Preprint

- Vertrauenswürdige Quelle

- Korrekturgelesen

von Ingrid Fadelli, Tech Xplore

Roboter, die die Aktionen und Bewegungen von Menschen in Echtzeit genau nachahmen können, könnten unglaublich nützlich sein, da sie lernen könnten, alltägliche Aufgaben auf spezifische Weise zu erledigen, ohne dass sie auf diesen Aufgaben umfassend vorprogrammiert werden müssen. Obwohl die Techniken zur Ermöglichung des Imitationslernens in den letzten Jahren erheblich verbessert wurden, wird ihre Leistung oft durch den Mangel an Übereinstimmung zwischen dem Körper eines Roboters und dem seines menschlichen Benutzers behindert.

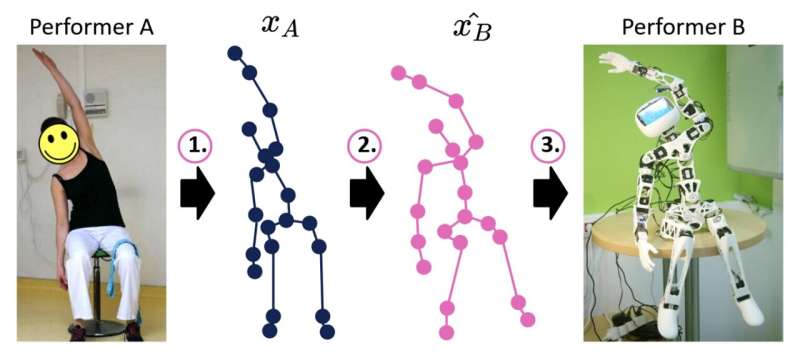

Forscher am U2IS, ENSTA Paris haben kürzlich ein neues tiefenlernbasiertes Modell vorgestellt, das die Fähigkeiten zur Bewegungsnachahmung humanoider Robotersysteme verbessern könnte. Dieses Modell, das in einer auf arXiv vorveröffentlichten Arbeit präsentiert wird, behandelt die Bewegungsnachahmung als drei verschiedene Schritte, die darauf abzielen, die Probleme bezüglich der Korrespondenz zwischen Mensch und Roboter zu verringern, die in der Vergangenheit berichtet wurden.

'Dieser Forschungsbeitrag in der Frühphase zielt darauf ab, die Online-Bewegungsnachahmung zwischen Mensch und Roboter zu verbessern, indem Sequenzen von Gelenkpositionen aus dem Bereich menschlicher Bewegungen in einen Bereich von Bewegungen übersetzt werden, die von einem bestimmten Roboter erreichbar sind und somit durch seine inkarniert werden', schrieben Louis Annabi, Ziqi Ma und Sao Mai Nguyen in ihrer Arbeit. 'Durch die Nutzung der Verallgemeinerungsfähigkeiten von Deep-Learning-Methoden gehen wir dieses Problem an, indem wir ein Encoder-Decoder-Neuronales Netzwerkmodell vorschlagen, das eine Übersetzung von Bereich zu Bereich durchführt.'

Das von Annabi, Ma und Nguyen entwickelte Modell unterteilt den Prozess der Bewegungsnachahmung zwischen Mensch und Roboter in drei Schlüsselschritte, nämlich Posenschätzung, Bewegungsumlenkung und Roboterkontrolle. Zunächst verwendet es Posenschätzalgorithmen, um Sequenzen von Skelett-Gelenkpositionen vorherzusagen, die den Bewegungen entsprechen, die von menschlichen Akteuren demonstriert werden.

Anschließend übersetzt das Modell diese vorhergesagte Sequenz von Skelett-Gelenkpositionen in ähnliche Gelenkpositionen, die realistisch vom Körper des Roboters produziert werden können. Schließlich werden diese übersetzten Sequenzen verwendet, um die Bewegungen des Roboters zu planen, was theoretisch zu dynamischen Bewegungen führen könnte, die dem Roboter helfen sollen, die anstehende Aufgabe zu erledigen.

'Um ein solches Modell zu trainieren, könnte man Paare von verbundenen Roboter- und menschlichen Bewegungen verwenden, [jedoch] sind solche gepaarten Daten in der Praxis extrem selten und mühsam zu sammeln', schrieben die Forscher in ihrer Arbeit. 'Deshalb wenden wir uns den Deep-Learning-Methoden für unpaare Bereich-zu-Bereich-Übersetzung zu, die wir anpassen, um die menschlich-roboterische Imitation durchzuführen.'

Annabi, Ma und Nguyen bewerteten die Leistung ihres Modells in einer Reihe von Vorversuchen, bei denen es mit einer einfacheren Methode zur Reproduktion von Gelenkorientierungen verglichen wurde, die nicht auf Deep Learning basiert. Ihr Modell erzielte nicht die erhofften Ergebnisse, was darauf hindeutet, dass aktuelle Deep-Learning-Methoden möglicherweise nicht in der Lage sind, Bewegungen in Echtzeit erfolgreich umzuleiten.

Die Forscher planen nun weitere Experimente durchzuführen, um potenzielle Probleme mit ihrem Ansatz zu identifizieren, so dass sie diese angehen und das Modell anpassen können, um seine Leistung zu verbessern. Die bisherigen Erkenntnisse des Teams deuten darauf hin, dass, obwohl unüberwachte Deep-Learning-Techniken zur Ermöglichung der Imitation in Robotern verwendet werden können, ihre Leistung noch nicht gut genug ist, um auf echten Robotern eingesetzt zu werden.

'Die zukünftige Arbeit wird die aktuelle Studie in drei Richtungen erweitern: Die weitere Untersuchung des Versagens der aktuellen Methode, wie im letzten Abschnitt erläutert, die Erstellung eines Datensatzes von gepaarten Bewegungsdaten aus der Mensch-zu-Mensch-Imitation oder der Roboter-zu-Mensch-Imitation und die Verbesserung der Modellarchitektur, um genauere Umleitungsvorhersagen zu erhalten', schließen die Forscher in ihrer Arbeit.

© 2024 Science X Network