Möchten Sie eine Deepfake erkennen? Die Augen könnten ein Hinweis sein.

Hinweise auf Deepfakes könnten in den Augen liegen.

Forscher der Universität Hull in England berichteten am 15. Juli, dass Augenreflexionen eine mögliche Möglichkeit bieten, KI-generierte Bilder von Personen zu erkennen. Der Ansatz beruht auf einer Technik, die auch von Astronomen zur Untersuchung von Galaxien verwendet wird.

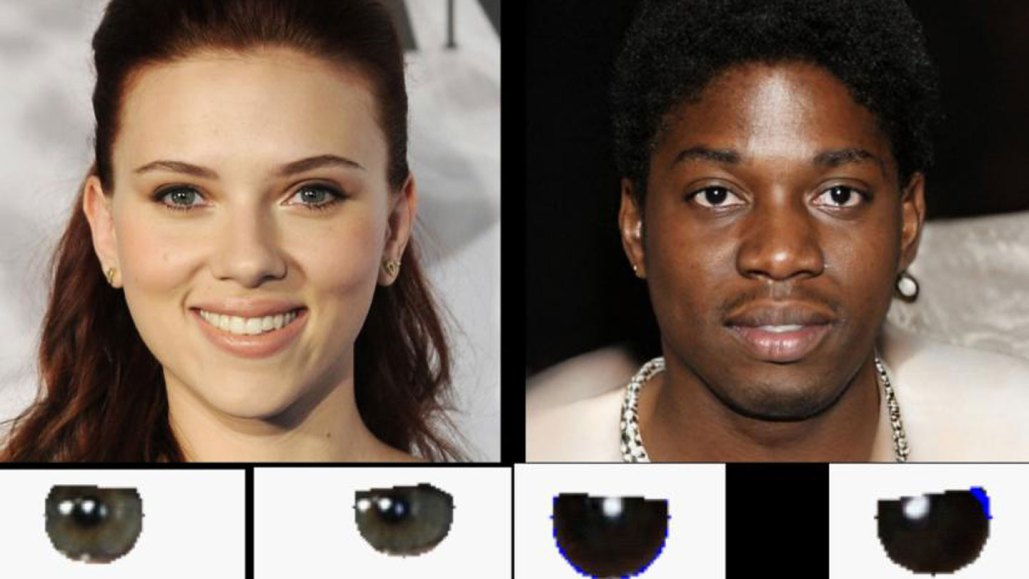

In echten Bildern stimmen die Lichtreflexionen in den Augäpfeln überein und zeigen beispielsweise die gleiche Anzahl von Fenstern oder Deckenleuchten. Aber in gefälschten Bildern gibt es oft Unstimmigkeiten in den Reflexionen. "Die Physik ist falsch", sagt Kevin Pimbblet, ein beobachtender Astronom, der an der Forschung mit der damaligen Doktorandin Adejumoke Owolabi beteiligt war und die Ergebnisse auf der National Astronomy Meeting der Royal Astronomical Society in Hull präsentierte.

Um die Vergleiche durchzuführen, benutzte das Team zunächst ein Computerprogramm, um die Reflexionen zu erkennen, und verwendete dann die Pixelwerte dieser Reflexionen, die die Intensität des Lichts an einem bestimmten Pixel darstellen, um den sogenannten Gini-Index zu berechnen. Astronomen nutzen den Gini-Index, der ursprünglich entwickelt wurde, um die Ungleichheit des Wohlstands in einer Gesellschaft zu messen, um zu verstehen, wie das Licht über ein Bild einer Galaxie verteilt ist. Wenn ein Pixel das gesamte Licht hat, beträgt der Index 1; wenn das Licht gleichmäßig über die Pixel verteilt ist, beträgt der Index 0. Diese Quantifizierung hilft Astronomen dabei, Galaxien in Kategorien wie Spiral- oder elliptische Galaxien einzuteilen.

In der aktuellen Arbeit ist der Unterschied in den Gini-Indizes zwischen den linken und rechten Augäpfeln der Hinweis auf die Authentizität des Bildes. Für etwa 70 Prozent der gefälschten Bilder, die die Forscher untersucht haben, war dieser Unterschied viel größer als der Unterschied bei echten Bildern. Bei echten Bildern tendierte der Unterschied dazu, nicht vorhanden oder nahezu nicht vorhanden zu sein.

"Wir können nicht sagen, dass ein bestimmter Wert Fälschung entspricht, aber wir können sagen, dass es ein Hinweis darauf ist, dass es ein Problem gibt und vielleicht sollte ein Mensch genauer hinsehen", erklärt Pimbblet.

Er betont, dass die Technik, die auch bei Videos funktionieren könnte, kein Allheilmittel zur Erkennung von Fälschungen ist. Ein echtes Bild kann beispielsweise wie eine Fälschung aussehen, wenn die Person blinzelt oder so nah an der Lichtquelle ist, dass nur ein Auge die Reflexion zeigt. Aber die Technik könnte ein Teil eines Testverfahrens sein - zumindest bis KI lernt, Reflexionen korrekt darzustellen.