Un système de téléopération basé sur la vision par ordinateur qui peut être appliqué à différents robots.

1er août 2023

feature

Cet article a été révisé selon le processus éditorial et les politiques de Science X. Les éditeurs ont mis en avant les attributs suivants tout en garantissant la crédibilité du contenu:

- fact-checké

- preprint

- source fiable

- corrigé

par Ingrid Fadelli, Tech Xplore

Les récents progrès dans les domaines de la robotique et de l'intelligence artificielle (IA) ont ouvert de nouvelles perspectives passionnantes pour la téléopération, c'est-à-dire le contrôle à distance de robots pour accomplir des tâches dans un lieu éloigné. Cela pourrait, par exemple, permettre aux utilisateurs de visiter des musées à distance, d'effectuer des tâches de maintenance ou techniques dans des espaces difficiles d'accès, ou d'assister à des événements à distance de manière plus interactive.

La plupart des systèmes de téléopération existants sont conçus pour être déployés dans des environnements spécifiques et utilisant un robot spécifique. Cela les rend difficiles à utiliser dans différents environnements réels, limitant considérablement leur potentiel.

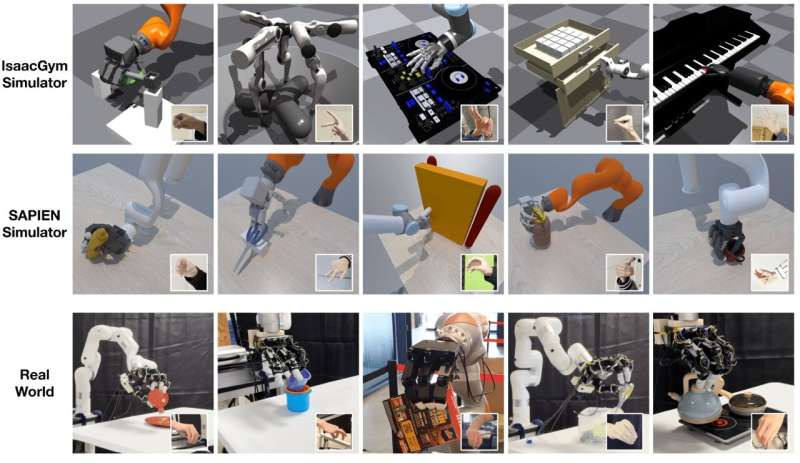

Des chercheurs de NVIDIA et de l'UC San Diego ont récemment créé AnyTeleop, un système de téléopération basé sur la vision par ordinateur qui pourrait être appliqué à une plus large gamme de scénarios. AnyTeleop, présenté dans un article pré-publié sur arXiv, permet le pilotage à distance de différents bras et mains robotiques pour réaliser différentes tâches manuelles.

« L'un des principaux objectifs de NVIDIA est de rechercher comment les humains peuvent enseigner aux robots à effectuer des tâches », a déclaré Dieter Fox, directeur principal de la recherche en robotique chez NVIDIA, responsable du laboratoire de recherche en robotique NVIDIA, professeur à l'École d'informatique et d'ingénierie Paul G. Allen de l'Université de Washington et responsable du laboratoire d'estimation d'état en robotique de l'UW, à Tech Xplore.

« Les travaux antérieurs se sont concentrés sur la façon dont un humain téléopère ou guide le robot, mais cette approche présente deux obstacles. Tout d'abord, la formation d'un modèle de pointe nécessite de nombreuses démonstrations. Deuxièmement, les configurations sont généralement dotées d'un appareil coûteux ou de capteurs et sont conçues uniquement pour un robot ou un environnement de déploiement particulier », a expliqué Fox.

L'objectif principal des travaux récents de Fox et de ses collègues était de créer un système de téléopération peu coûteux, facile à déployer et généralisable à différentes tâches, environnements et systèmes robotiques. Pour entraîner leur système, les chercheurs ont téléopéré à la fois des robots virtuels dans des environnements simulés et des robots réels dans un environnement physique, ce qui a permis de réduire la nécessité d'acheter et d'assembler de nombreux robots.

« AnyTeleop est un système de téléopération basé sur la vision qui permet aux humains d'utiliser leurs mains pour contrôler des systèmes de main-bras robotiques habiles », a expliqué Fox. « Le système suit les poses de la main humaine à partir d'une ou de plusieurs caméras, puis les redirige pour contrôler les doigts d'une main robotique à plusieurs doigts. Le point du poignet est utilisé pour contrôler le mouvement du bras du robot avec un planificateur de mouvement alimenté par CUDA ».

Contrairement à la plupart des autres systèmes de téléopération présentés dans des études antérieures, AnyTeleop peut être interfacé avec différents bras robotiques, mains robotiques, configurations de caméras et environnements simulés ou réels. De plus, il peut être utilisé dans des scénarios où les utilisateurs sont à proximité ou à des emplacements éloignés.

La plateforme AnyTeleop peut également aider à collecter des données de démonstration humaines (c'est-à-dire des données représentant les mouvements et actions que les humains effectuent lorsqu'ils exécutent des tâches manuelles spécifiques). Ces données pourraient à leur tour être utilisées pour mieux former les robots à accomplir de manière autonome différentes tâches.

« La principale avancée d'AnyTeleop réside dans sa conception généralisable et facile à déployer », a déclaré Fox. « Une application potentielle consiste à déployer des environnements virtuels et des robots virtuels dans le cloud, permettant aux utilisateurs périphériques disposant d'ordinateurs d'entrée de gamme et de caméras (comme un iPhone ou un PC) de les téléopérer. Cela pourrait révolutionner la chaîne de données pour les chercheurs et les développeurs industriels qui enseignent aux robots de nouvelles compétences ».

Lors des tests initiaux, AnyTeleop s'est révélé plus performant qu'un système de téléopération existant conçu pour un robot spécifique, même lorsqu'il était appliqué à ce robot. Cela souligne sa valeur en tant qu'outil pour améliorer les applications de téléopération.

NVIDIA prévoit de publier prochainement une version open-source du système AnyTeleop, permettant aux équipes de recherche du monde entier de le tester et de l'appliquer à leurs robots. À l'avenir, cette nouvelle plateforme prometteuse pourrait contribuer à la mise à l'échelle des systèmes de téléopération, tout en facilitant la collecte de données d'entraînement pour les manipulateurs robotiques.

« Nous prévoyons maintenant d'utiliser les données collectées pour explorer l'apprentissage robotique », a ajouté Fox. « Une priorité notable pour l'avenir est de surmonter les écarts de domaine lors du transfert de modèles de robot de la simulation au monde réel ».

© 2023 Science X Network