Nouveau cadre permet des mouvements agiles semblables à ceux des animaux dans les robots à quatre pattes

13 juillet 2024

Cet article a été examiné selon le processus éditorial et les politiques de Science X. Les éditeurs ont mis en évidence les attributs suivants tout en veillant à la crédibilité du contenu :

- vérifié par des faits

- publication évaluée par des pairs

- source fiable

- corrigé

par Ingrid Fadelli, Tech Xplore

Les animaux à quatre pattes sont intrinsèquement capables de mouvements agiles et adaptables, ce qui leur permet de se déplacer sur une large gamme de terrains. Au cours des dernières décennies, les roboticistes du monde entier ont cherché à reproduire efficacement ces mouvements chez les robots quadrupèdes (c'est-à-dire à quatre pattes).

Il a été constaté que les modèles computationnels entraînés via l'apprentissage par renforcement permettent d'obtenir des résultats particulièrement prometteurs pour permettre la locomotion agile chez les robots quadrupèdes. Cependant, ces modèles sont généralement formés dans des environnements simulés et leurs performances peuvent parfois décliner lorsqu'ils sont appliqués à des robots réels dans des environnements du monde réel.

Des approches alternatives pour réaliser une locomotion agile chez les quadrupèdes utilisent des séquences d'images d'animaux en mouvement collectées par des capteurs de mouvement et des caméras comme démonstrations, qui sont utilisées pour former des contrôleurs (c'est-à-dire des algorithmes pour exécuter les mouvements des robots). Cette approche, appelée « apprentissage par imitation », a permis la reproduction de mouvements semblables à ceux des animaux sur certains robots quadrupèdes.

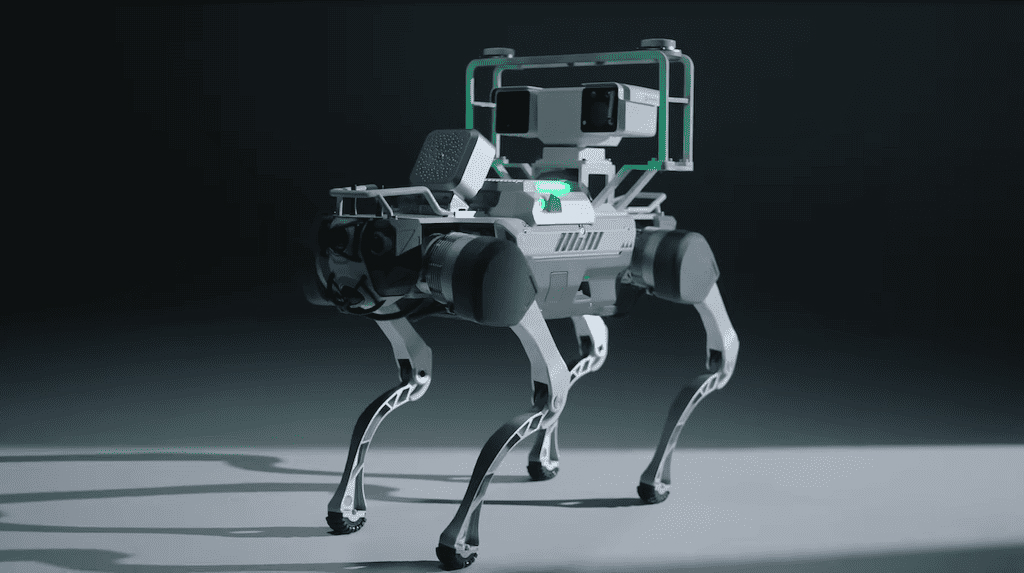

Des chercheurs de Tencent Robotics X en Chine ont récemment introduit un nouveau cadre hiérarchique qui pourrait faciliter l'exécution de mouvements agiles semblables à ceux des animaux chez les robots à quatre pattes. Ce cadre, présenté dans un article publié dans Nature Machine Intelligence, a d'abord été appliqué à un robot quadrupède appelé MAX, donnant des résultats très prometteurs.

« De nombreux efforts ont été déployés pour réaliser une locomotion agile chez les robots quadrupèdes via des contrôleurs classiques ou des approches d'apprentissage par renforcement », ont écrit Lei Han, Qingxu Zhu et leurs collègues dans leur article. "Ces méthodes reposent généralement sur des modèles physiques ou des récompenses fabriquées à la main pour décrire de manière précise le système spécifique, plutôt que sur une compréhension généralisée comme le font les animaux. Nous proposons un cadre hiérarchique pour construire des connaissances au niveau primitif, environnemental et stratégique, toutes pré-entraînables, réutilisables et enrichissables pour les robots à pattes."

Le nouveau cadre proposé par les chercheurs couvre trois étapes d'apprentissage par renforcement, chacune se concentrant sur l'extraction de connaissances à un niveau différent de tâches de locomotion et de perception des robots. Le contrôleur de l'équipe à chacun de ces stades d'apprentissage est appelé contrôleur moteur primitif (PMC), contrôleur moteur primitif environnemental (EPMC) et contrôleur moteur primitif stratégique-environnemental (SEPMC), respectivement.

« Le module primitif résume les connaissances à partir de données de mouvement animal, où, inspiré par de grands modèles pré-entraînés en compréhension du langage et des images, nous introduisons des modèles génératifs profonds pour produire des signaux de contrôle moteur stimulant les robots quadrupèdes à agir comme de vrais animaux », ont écrit les chercheurs. « Nous façonnons ensuite diverses capacités de traversée à un niveau supérieur pour s'aligner avec l'environnement en réutilisant le module primitif. Enfin, un module stratégique est formé, se concentrant sur des tâches complexes en aval en réutilisant les connaissances des niveaux précédents. »

Les chercheurs ont évalué leur cadre proposé dans une série d'expériences, où ils l'ont appliqué à un robot quadrupède appelé MAX. Deux robots MAX ont été spécifiquement utilisés pour concourir dans un jeu de type tag et le cadre a été utilisé pour contrôler leurs mouvements.

« Nous appliquons les contrôleurs hiérarchiques formés au robot MAX, un robot quadrupède développé en interne, pour imiter les animaux, traverser des obstacles complexes et jouer dans un jeu de tag multijoueur conçu et stimulant, où l'agilité et la stratégie vivantes émergent chez les robots », ont écrit les chercheurs.

Lors de leurs premiers tests, les chercheurs ont constaté que leur modèle permettait au robot MAX de traverser avec succès différents environnements, réalisant des mouvements agiles ressemblant à ceux des animaux. À l'avenir, le modèle pourrait être adapté et appliqué à d'autres robots à quatre pattes, facilitant potentiellement leur déploiement dans des environnements du monde réel.

Plus d'informations : Lei Han et al, Lifelike agility and play in quadrupedal robots using reinforcement learning and generative pre-trained models, Nature Machine Intelligence (2024). DOI : 10.1038/s42256-024-00861-3

© 2024 Science X Network